Die Gestaltung des ETL-Prozesses (Extract, Transform, Load) nimmt in modernen Data-Warehouse-(DW-)Projekten eine zentrale Stellung ein. Der ETL-Prozess ermöglicht die Integration, Bereinigung und Speicherung von Daten aus verschiedenen Quellen im Data Warehouse, um sie für Analysezwecke zugänglich zu machen. Eine der grundlegenden Entscheidungen, die bei der Gestaltung dieses Prozesses getroffen werden muss, ist die Wahl zwischen einem Full-Data-Load und einem Difference-Load. Diese Entscheidung hat erhebliche Auswirkungen auf die Effizienz, Skalierbarkeit und Aktualität des Data Warehouse.

Die Gestaltung des ETL-Prozesses (Extract, Transform, Load) nimmt in modernen Data-Warehouse-(DW-)Projekten eine zentrale Stellung ein. Der ETL-Prozess ermöglicht die Integration, Bereinigung und Speicherung von Daten aus verschiedenen Quellen im Data Warehouse, um sie für Analysezwecke zugänglich zu machen. Eine der grundlegenden Entscheidungen, die bei der Gestaltung dieses Prozesses getroffen werden muss, ist die Wahl zwischen einem Full-Data-Load und einem Difference-Load. Diese Entscheidung hat erhebliche Auswirkungen auf die Effizienz, Skalierbarkeit und Aktualität des Data Warehouse.

Dieser Artikel bietet eine detaillierte Analyse der Ansätze, erläutert die spezifischen Anforderungen und Einsatzmöglichkeiten und gibt eine fundierte Empfehlung, wann welcher Ansatz geeignet ist.

Inhalt dieser Seite

Vollständiges Laden im Data Warehouse

Full-Data-Load (Vollständige Beladung) bezeichnet ein Verfahren, bei dem alle relevanten Daten aus den Quellsystemen extrahiert und in das Data Warehouse geladen werden. Dabei ist es unerheblich, ob diese Daten seit dem letzten Ladevorgang verändert wurden oder nicht. Im Rahmen jeder Beladung erfolgt eine vollständige Neuorganisation des Datenbestandes im Data Warehouse. Dies impliziert, dass das Data Warehouse nach jedem Ladezyklus eine vollständige Kopie der Quellendaten enthält.

Ablauf beim Full-Data-Load

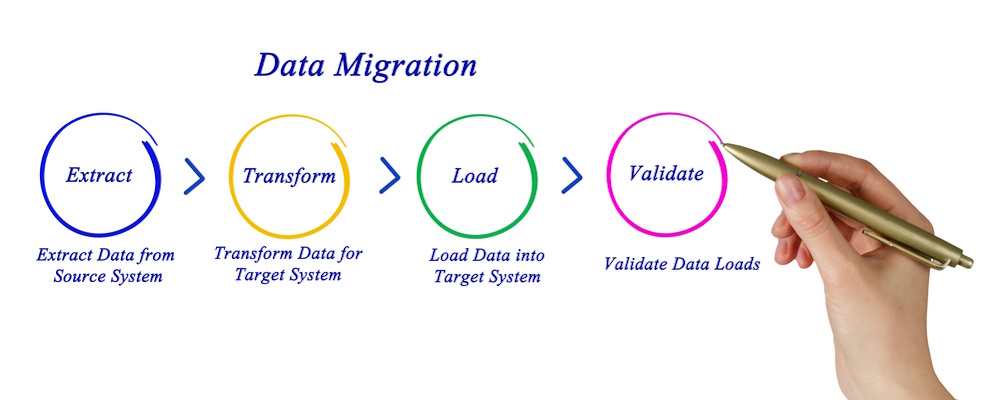

Der Ablauf des Full-Data-Load-Prozesses umfasst die folgenden Schritte:

- Im Rahmen der Transformation werden die extrahierten Daten in eine Form überführt, die den erforderlichen Formaten, Strukturen und Qualitätsstandards entspricht.

- Im Rahmen des Ladevorgangs werden die zuvor extrahierten Daten in das Data Warehouse übertragen.

- Im Anschluss werden die transformierten Daten vollständig in die Zieltabellen des Data Warehouses geladen. In der Konsequenz werden die bestehenden Daten in der Regel gelöscht oder überschrieben.

Vorteile

- Einfachheit: Der Full-Data-Load-Prozess ist relativ einfach zu implementieren, da keine Mechanismen zur Identifizierung geänderter Daten erforderlich sind.

- Datenintegrität: Durch das vollständige Überschreiben der Daten wird sichergestellt, dass das Data Warehouse eine genaue Kopie der Quellendaten enthält, was potenzielle Inkonsistenzen minimiert.

- Wiederherstellung: Bei einem Fehler im ETL-Prozess ist die Wiederherstellung oft einfacher, da der Prozess einfach erneut ausgeführt werden kann.

Nachteile

- Hohe Ressourcenanforderungen: Da bei jedem Ladevorgang alle Daten neu geschrieben werden, kann dieser Ansatz sehr ressourcenintensiv sein, insbesondere bei großen Datenmengen.

- Lange Ladezeiten: Die vollständige Beladung kann erhebliche Zeit in Anspruch nehmen, was die Aktualität der Daten im Data Warehouse beeinträchtigen kann.

- Datenverlust: Wenn nicht sorgfältig implementiert, besteht das Risiko, dass durch das Überschreiben von Daten Änderungen oder historische Daten verloren gehen.

Inkrementelles Laden im DWH

Die Differenzenbeladung oder auch Inkrementelles Laden zielt darauf ab, lediglich diejenigen Daten zu laden, die sich seit dem letzten Ladevorgang geändert haben. Diese Vorgehensweise wird auch als inkrementelle Beladung bezeichnet und fokussiert sich auf die Identifikation von Änderungen in den Quellsystemen sowie deren Übertragung in das Data Warehouse.

Ablauf beim inkrementellen Ladeprozess

Der inkrementelle Ladeprozess im DWH umfasst die folgenden Schritte:

- Im Rahmen des Differenzenbeladungsprozesses erfolgt lediglich die Extraktion derjenigen Daten aus den Quellsystemen, die sich seit dem letzten Ladevorgang geändert haben. Dies bedingt in der Regel die Implementierung spezifischer Mechanismen zur Änderungserkennung, wie beispielsweise Zeitstempel oder Change Data Capture.

- Im Anschluss erfolgt die Transformation der extrahierten Daten, um die erforderlichen Standards zu erfüllen.

- Im letzten Schritt werden die transformierten, geänderten Daten in die entsprechenden Tabellen des Data Warehouses eingefügt oder aktualisiert. Historische Daten hingegen bleiben in der Regel unverändert bestehen.

Vorteile

- Effizienz: Da nur geänderte Daten geladen werden, sind die Ressourcenanforderungen und Ladezeiten erheblich geringer als bei der vollständigen Beladung.

- Aktualität: Durch die schnellere Beladung können Daten häufiger aktualisiert werden, was zu einer höheren Datenaktualität führt.

- Bewahrung historischer Daten: Die Differenzenbeladung ermöglicht die Beibehaltung historischer Daten und erleichtert so die Nachverfolgung von Datenänderungen über die Zeit.

Nachteile

- Komplexität: Die Implementierung der Differenzenbeladung erfordert komplexere Mechanismen zur Erkennung von Änderungen und zur Verwaltung historischer Daten.

- Fehleranfälligkeit: Fehler in der Änderungserkennung oder beim Laden der Daten können zu Inkonsistenzen im Data Warehouse führen.

- Höherer Pflegeaufwand: Die fortlaufende Verwaltung und Pflege der Differenzenbeladung erfordert mehr Aufwand als die vollständige Beladung.

Vergleich der beiden Ansätze

Die Hauptunterschiede zwischen Full-Data-Load und Differenzenbeladung lassen sich wie folgt zusammenfassen:

| Merkmal | Full-Data-Load | Inkrementelles Laden |

|---|---|---|

| Datenvolumen | Vollständige Datenmenge wird geladen | Nur geänderte Daten werden geladen |

| Ressourcenanforderungen | Hoch | Gering |

| Ladezeit | Lang | Kurz |

| Datenaktualität | Gering (seltener geladen) | Hoch (häufiger geladen) |

| Komplexität | Niedrig | Hoch |

| Risiko von Datenverlusten | Hoch (bei nicht korrekt implementierter Löschung) | Gering (historische Daten bleiben bestehen) |

| Implementierungsaufwand | Gering | Hoch |

Empfehlung für Ihren ETL Prozess

Die Entscheidung zwischen Full-Data-Load und Differenzenbeladung hängt stark von den spezifischen Anforderungen und Rahmenbedingungen des Data Warehouse-Projekts ab. Im Allgemeinen lässt sich folgende Empfehlung aussprechen:

- Full-Data-Load: Dieser Ansatz ist geeignet für kleinere Datenmengen, einfache Anwendungsfälle und Szenarien, in denen Datenkonsistenz und Einfachheit im Vordergrund stehen. Er eignet sich auch für Situationen, in denen die Ladefrequenz niedrig ist oder die Datenquellen keine Änderungshistorie bereitstellen können.

- Differenzenbeladung: Dieser Ansatz ist ideal für große Datenmengen, bei denen die Ladezeiten und Ressourcenanforderungen kritisch sind. Er eignet sich auch für Anwendungen, die häufige Aktualisierungen erfordern und bei denen die Historie der Daten von Bedeutung ist. Die höhere Komplexität und der größere Implementierungsaufwand werden durch die bessere Skalierbarkeit und Aktualität der Daten ausgeglichen.

In Bezugnahme auf die zuvor angeführten Ausführungen lässt sich zusammenfassend feststellen, dass die Differenzenbeladung als Methode der Datenverwaltung in Data-Warehouse-Projekten eine bevorzugte Anwendung findet. Dies begründet sich in den Vorteilen einer effizienteren und aktuelleren Datenverwaltung, welche durch diese Methode gewährleistet wird. Die Full-Data-Load stellt jedoch weiterhin eine wertvolle Option für spezifische Anwendungsfälle dar, in denen die einfache Handhabung sowie die Datenintegrität von zentraler Bedeutung sind.

Es stellt sich die Frage, ob neben den beiden hier vorgestellten Verfahren auch andere Methoden Anwendung finden?

In der Tat existieren weitere Ansätze zur Datenbeladung in einem Data Warehouse, die neben der Full-Data-Load und Differenzenbeladung in die Überlegungen mit einbezogen werden können. In Abhängigkeit von der konkreten Anwendungssituation sowie den systemseitigen Anforderungen können diese Methoden als nützlich erachtet werden. Im Folgenden erfolgt eine Vorstellung ausgewählter alternativer Ansätze sowie eine Diskussion deren Vor- und Nachteile.

Near-Real-Time ETL (Near-Real-Time Data Load)

Definition

Der Near-Real-Time ETL-Ansatz zielt darauf ab, Daten nahezu in Echtzeit aus den Quellsystemen zu extrahieren, zu transformieren und zu laden. Im Gegensatz zur traditionellen Batch-Verarbeitung, bei der Daten in größeren Intervallen (z.B. täglich oder stündlich) verarbeitet werden, versucht Near-Real-Time ETL, die Latenzzeit zwischen der Datenerfassung und der Verfügbarkeit im Data Warehouse auf ein Minimum zu reduzieren.

Ablauf

- Ereignisgesteuerte Extraktion: Daten werden sofort nach einer Änderung oder einem Ereignis im Quellsystem extrahiert.

- Streaming-Transformation: Die Daten werden kontinuierlich transformiert, oft mit Hilfe von Stream-Processing-Tools.

- Kontinuierliches Laden: Die transformierten Daten werden unmittelbar in das Data Warehouse geladen, oft mit minimaler Verzögerung.

Vorteile

- Minimale Latenz: Daten stehen nahezu in Echtzeit zur Verfügung, was für zeitkritische Anwendungen wichtig ist.

- Kontinuierliche Aktualität: Die Daten im Data Warehouse sind immer auf dem neuesten Stand.

Nachteile

- Hohe Komplexität: Die Implementierung von Near-Real-Time ETL- Prozess erfordert eine komplexe Architektur und erweiterte Technologien.

- Erhöhte Systembelastung: Der kontinuierliche Datenfluss kann eine hohe Belastung für die Infrastruktur darstellen.

Anwendungsfälle

Dieser Ansatz eignet sich besonders für Branchen, in denen Echtzeitdaten entscheidend sind, wie z.B. im Finanzsektor, im E-Commerce oder in der Logistik.

Micro-Batching

Definition

Micro-Batching ist eine Hybridstrategie zwischen klassischer Batch-Verarbeitung und Near-Real-Time ETL. Bei diesem Ansatz werden Daten in sehr kurzen Intervallen gesammelt und verarbeitet, oft im Minuten- oder Sekundenbereich. Dies ermöglicht eine schnellere Aktualisierung als bei herkömmlichen Batch-Prozessen, während die Komplexität und die Systemanforderungen geringer sind als bei Near-Real-Time ETL.

Ablauf

- Kurze Intervall-Extraktion: Daten werden in kleinen Chargen in kurzen Intervallen extrahiert.

- Batch-Transformation: Die extrahierten Daten werden in kurzen Intervallen transformiert.

- Batch-Laden: Die transformierten Daten werden in das Data Warehouse geladen, ebenfalls in kurzen Intervallen.

Vorteile

- Schnellere Datenverfügbarkeit als bei traditionellen Batches: Ermöglicht zeitnähere Datenanalyse.

- Weniger komplex als Near-Real-Time ETL: Kombiniert einige Vorteile der Echtzeitverarbeitung mit der Stabilität der Batch-Verarbeitung.

Nachteile

- Balancing erforderlich: Die Wahl des richtigen Intervalls ist entscheidend, um die Vorteile zu maximieren und Systembelastungen zu minimieren.

- Zwischenlösung: Kann nicht die volle Aktualität von Near-Real-Time ETL bieten.

Anwendungsfälle

Micro-Batching eignet sich für Unternehmen, die eine schnellere Datenaktualisierung als in herkömmlichen Batch-Prozessen benötigen, aber die Komplexität von Near-Real-Time ETL vermeiden möchten.

Trickle-and-Flip (T&F)

Definition

Trickle-and-Flip ist eine Strategie, die in Data Warehouses eingesetzt wird, die große Datenmengen handhaben müssen und bei denen sowohl historische Daten als auch aktuelle Daten für Analysen benötigt werden. Dabei werden inkrementelle Daten (Trickle) laufend in temporäre Tabellen geladen und zu einem festgelegten Zeitpunkt auf die Haupttabellen „umgeschaltet“ (Flip).

Ablauf

- Trickle: Inkrementelle Daten werden kontinuierlich in eine temporäre Tabelle geladen.

- Flip: Zu einem bestimmten Zeitpunkt wird die temporäre Tabelle in die Haupttabelle integriert, wobei eine Umbenennung oder ein Austausch der Tabellen stattfindet.

Vorteile

- Optimierte Ladeprozesse: Ermöglicht die kontinuierliche Datenverarbeitung ohne Unterbrechung der Analysen.

- Effiziente Ressourcenverwendung: Kombiniert die Vorteile der inkrementellen Beladung mit der Fähigkeit, große Datenmengen zu verarbeiten.

Nachteile

- Komplexität: Die Implementierung erfordert eine genaue Planung und Überwachung der Flip-Prozesse.

- Synchronisationsprobleme: Es können Probleme auftreten, wenn die Flip-Operation nicht korrekt durchgeführt wird.

Anwendungsfälle

Dieser Ansatz eignet sich besonders für sehr große Data Warehouses, in denen sowohl aktuelle als auch historische Daten für komplexe Analysen benötigt werden.

Delta Load mit SCD (Slowly Changing Dimensions)

Definition

Der Delta Load mit SCD ist ein spezieller Ansatz der Differenzenbeladung, bei dem nicht nur aktuelle Änderungen, sondern auch historische Änderungen erfasst werden. SCD bezieht sich auf Techniken zur Handhabung von Änderungen an Dimensionen, bei denen historische Werte beibehalten werden müssen (z.B. bei Änderungen von Kundenadressen).

In einem früheren Artikel wurde das SCD bereits vorgestellt. Für weiterführende Informationen wird auf den Artikel über Slowly Changing Dimensions verwiesen.

Ablauf

- Erkennung von Änderungen: Delta Load identifiziert Änderungen an den Daten.

- Anwendung von SCD-Techniken: Je nach SCD-Typ (z.B. Typ 1, Typ 2, Typ 3) werden die Daten entsprechend aktualisiert oder historische Datenversionen gespeichert.

Vorteile

- Erhaltung historischer Daten: Ermöglicht eine genaue Nachverfolgung von Änderungen über die Zeit.

- Flexibilität: Unterstützt verschiedene SCD-Typen, um unterschiedliche Anforderungen zu erfüllen.

Nachteile

- Erhöhte Komplexität: Die Verwaltung von SCD erfordert eine durchdachte Implementierung und Wartung.

- Längere Ladezeiten: Die Handhabung historischer Daten kann die Ladeprozesse verlängern.

Anwendungsfälle

Dieser Ansatz ist ideal für Unternehmen, die umfassende historische Analysen benötigen, insbesondere bei Dimensionen, die sich im Laufe der Zeit ändern.

Neben der Full-Data-Load und Differenzenbeladung existieren weitere Ansätze wie das Near-Real-Time ETL, das Micro-Batching, das Trickle-and-Flip und das Delta Load mit SCD, welche in Abhängigkeit von den spezifischen Anforderungen des Data-Warehouse-Projekts in Erwägung gezogen werden sollten. Die grundlegenden Methoden Full-Data-Load und Differenzenbeladung bieten zwar eine solide Grundlage für die Datenverarbeitung und -aktualisierung, doch die alternativen Ansätze eröffnen ein erweitertes Spektrum an Optimierungsmöglichkeiten.

Die Auswahl des adäquaten Ansatzes ist von den individuellen Anforderungen, der Datenmenge, der erforderlichen Aktualität sowie den verfügbaren Ressourcen abhängig. In der Praxis findet häufig eine Kombination der genannten Ansätze Anwendung, um die Vorteile der jeweiligen Methoden zu maximieren.

Hinterlasse jetzt einen Kommentar