Heute stehen Unternehmen vor der Herausforderung, die effizienteste Methode zur Integration ihrer vielfältigen Datenquellen zu wählen. Die Methoden ETL und ELT bieten jeweils einzigartige Vorteile für die Datenverarbeitung und Analyse, welche die Grundlage für geschäftskritische Entscheidungen bilden. Diese Wahl ist weit mehr als eine technische Überlegung; sie beeinflusst maßgeblich die Flexibilität, wie Organisationen auf Marktveränderungen reagieren und wie schnell sie auf Kundenbedürfnisse eingehen können. Während ETL die Daten vor dem Laden in ein Datenziel transformiert, passt ELT die Daten nach dem Laden an, was die Nutzung moderner Datenbanksysteme und Cloud-Services ermöglicht.

Die Unterschiede zwischen ETL und ELT spiegeln sich nicht nur in der Reihenfolge ihrer Prozessschritte wider, sondern auch in der Art und Weise, wie sie mit den sich ständig verändernden Datenmengen und -formaten umgehen. ETL-Verfahren sind ideal für Szenarien, in denen Daten vor der Analyse umfassend aufbereitet werden müssen. Diese Methode unterstützt Unternehmen dabei, ein hohes Maß an Datenqualität und -konsistenz zu gewährleisten. ELT hingegen ist prädestiniert für Umgebungen, die eine hohe Verarbeitungsgeschwindigkeit erfordern und wo Analyseprozesse in der gleichen Umgebung stattfinden, in der die Daten gespeichert sind. Dies ist besonders relevant, wenn es darum geht, Echtzeitdaten für sofortige analytische Einsichten zu nutzen.

Zudem bieten ELT-Prozesse eine bessere Skalierbarkeit in Cloud-Infrastrukturen und die Möglichkeit, Big Data effizienter zu handhaben. Die Leistungsfähigkeit moderner Datenbanksysteme wird so voll ausgenutzt, um komplexe Transformationen und Analysen direkt auf den geladenen Rohdaten durchzuführen. Dadurch können Unternehmen agiler agieren und schneller auf Veränderungen reagieren.

Die Entscheidung für den einen oder anderen Ansatz sollte jedoch nicht isoliert getroffen werden. Sie sollte Teil einer umfassenden Datenstrategie sein, die die spezifischen Geschäftsziele, die vorhandene IT-Infrastruktur, die Fähigkeiten des Personals und die Compliance-Anforderungen berücksichtigt. In diesem Artikel werden wir einen tieferen Einblick in die strategischen Überlegungen geben, die hinter der Auswahl von ETL gegenüber ELT stehen, und beleuchten, wie Unternehmen die Vorteile beider Methoden in Einklang bringen können, um eine robuste und zukunftsfähige Dateninfrastruktur zu schaffen.

Traditionelle Datenverarbeitung mit ETL

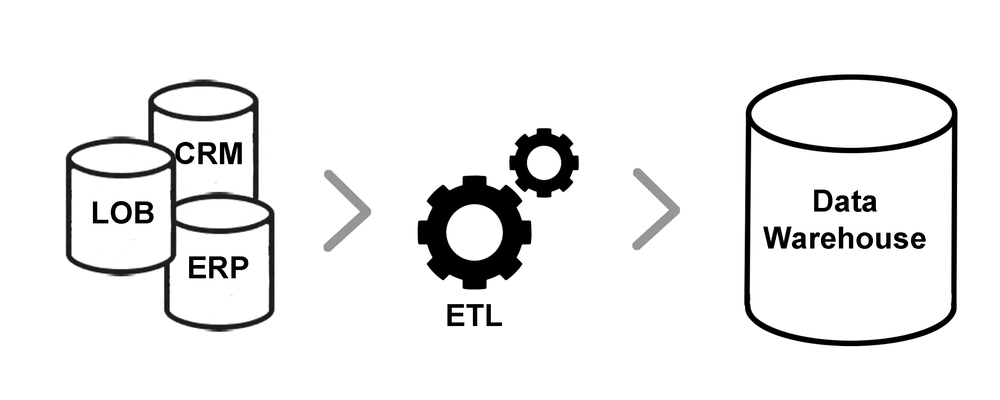

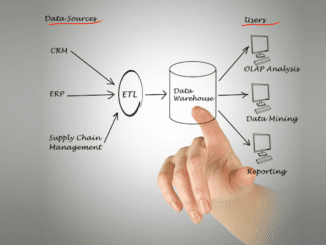

ETL ist eine bewährte Methode der Datenintegration, die seit den frühen Tagen der Datenlagerung eingesetzt wird. Der Prozess umfasst das Extrahieren von Daten aus verschiedenen Quellen, das Transformieren dieser Daten in ein formatiertes Schema, das Analyse und Reporting unterstützt, und das Laden der transformierten Daten in ein Ziel-Datenlager oder Data Warehouse. ETL wurde entwickelt, um mit den Ressourcenbeschränkungen älterer Datenbanktechnologien und Hardware umzugehen, indem die Ressourcenintensität der Transformation außerhalb der Datenbank durchgeführt wurde.

In einem ETL-Prozess wird besonderer Wert auf die Transformationsschritte gelegt, die vor dem Laden der Daten erfolgen. Dies kann Vorteile in Bezug auf die Datenqualität und -konsistenz bieten, da die Daten gründlich gereinigt und strukturiert werden, bevor sie das Data Warehouse erreichen. Allerdings kann ETL auch zeitaufwändig und ressourcenintensiv sein, was zu Verzögerungen in der Verfügbarkeit der Daten für die Analyse führen kann.

Evolution der Datenstrategien mit ELT

ELT stellt eine evolutionäre Veränderung in der Datenverarbeitung dar, die durch die Einführung leistungsstärkerer Datenbanktechnologien und Cloud-Datenplattformen ermöglicht wurde. Bei diesem Ansatz werden die Daten zunächst in ihre Rohform in das Data Warehouse oder einen Data Lake geladen. Die Transformation erfolgt innerhalb des Zielumfelds, was die Nutzung der dort verfügbaren Rechenressourcen ermöglicht.

Der Hauptvorteil von ELT liegt in der Geschwindigkeit und Agilität. Da die Daten schneller geladen werden können, sind sie früher für die Analyse verfügbar. Zudem ermöglicht ELT die Nutzung fortschrittlicher Analysefunktionen und maschinellen Lernens direkt in der Datenplattform, was eine flexiblere und skalierbarere Analyseumgebung schafft.

Unterschiede in Anwendungsbereichen

Die Wahl zwischen ETL und ELT hängt von verschiedenen Faktoren ab, darunter die Art der Daten, die Komplexität der Datenverarbeitung, die erforderliche Geschwindigkeit der Datenverfügbarkeit und die spezifischen Anforderungen des Unternehmens. ETL bleibt eine starke Wahl für Szenarien, in denen Daten aus mehreren Quellen konsolidiert und standardisiert werden müssen, bevor sie für Berichte und Analysen verwendet werden. Unternehmen, die eine hohe Datenqualität und Governance benötigen, könnten sich für ETL entscheiden, um sicherzustellen, dass ihre Daten vor dem Laden gereinigt und konform sind.

ELT hingegen ist ideal für Szenarien, in denen die Geschwindigkeit der Datenbereitstellung kritisch ist und wo Daten in ihrer natürlichen Form für eine Vielzahl von Analyse- und Geschäftsanforderungen benötigt werden. Organisationen, die die Flexibilität der Cloud nutzen und komplexe Analysen durchführen möchten, tendieren häufig zu ELT-Lösungen.

Sowohl ETL als auch ELT spielen eine wichtige Rolle in der modernen Datenarchitektur. Die Entscheidung zwischen den beiden sollte auf einer gründlichen Bewertung der spezifischen Geschäfts- und Datenerfordernisse basieren. Die Weiterentwicklung von Datenplattformen und die steigenden Anforderungen an Echtzeitanalysen und -entscheidungen dürften die Präferenz für ELT weiter verstärken, während ETL für bestimmte Anwendungsfälle, die eine hohe Datenqualität und -integrität erfordern, weiterhin von Bedeutung sein wird.

Wer unterstützt was?

Im Bereich der ETL-Software bieten verschiedene Hersteller Lösungen an, die entweder für ETL-Prozesse, ELT-Prozesse oder beide verwendet werden können. Hier sind fünf Hersteller, die Software für ETL-Prozesse anbieten:

- IBM Infosphere Datastage: Eine umfassende ETL-Lösung, die für ihre Geschwindigkeit durch Lastausgleich und Parallelverarbeitung bekannt ist und eine breite Palette von Datenintegrationsmöglichkeiten bietet.

- Oracle Data Integrator: Bietet eine leistungsstarke Plattform für die Erstellung, den Einsatz und das Management von Datenlagerkomplexen mit einer großen Auswahl an Out-of-the-Box-Connectors.

- Microsoft SQL Server Integration Services (SSIS): Eine Unternehmenslösung für Datenintegration und Transformation, die eine Vielzahl von Connectors zur Datenextraktion aus unterschiedlichen Quellen bereitstellt.

- Talend Open Studio: Ein beliebtes Open-Source-Tool für Datenintegration, das eine benutzerfreundliche grafische Benutzeroberfläche für die Erstellung von Datenpipelines bietet.

- Pentaho Data Integration: Ermöglicht das Erfassen von Daten aus verschiedenen Quellen, ihre Bereinigung und Speicherung in einem einheitlichen und konsistenten Format.

Für ELT-Prozesse oder kombinierte ETL/ELT-Prozesse gibt es ebenfalls eine Reihe von Anbietern:

- Fivetran: Bietet eine Reihe von Anwendungsfällen, darunter Datenbankreplikation und all-in-one Marketinganalysen, indem Daten aus verschiedenen Analyseplattformen in ein Ziel exportiert werden.

- AWS Glue: Ein serverloser ETL-Dienst von Amazon, der Datenentdeckung, -vorbereitung, -integration und -transformation für Analysezwecke ermöglicht.

- Azure Data Factory: Ein serverloser Datenintegrationsdienst von Microsoft, der ETL- und ELT-Prozesse in der Azure-Cloud-Umgebung ohne Code-Erstellung ermöglicht.

- Stitch: Ein Cloud-basierter Datenintegrationsdienst, der die schnelle Bewegung von Daten aus über 140 Quellen zu Datenlagern ermöglicht und kein Coding erfordert.

- Dataddo: Ein No-Code, Cloud-basiertes ETL-Tool, das sowohl technischen als auch nicht-technischen Teammitgliedern hilft, Daten zu integrieren.

Diese Hersteller bieten eine Vielzahl von Lösungen, die auf unterschiedliche Geschäftsanforderungen und technische Umgebungen zugeschnitten sind. Von leistungsstarken Unternehmensplattformen bis hin zu flexiblen Cloud-Diensten und Open-Source-Optionen ist für jedes Unternehmen und jede Anforderung etwas dabei

Hinterlasse jetzt einen Kommentar